- 1 El cambio de paradigma: De la computación en la palma a la computación en el entorno

- 2 La soberanía del NPU: Procesamiento local vs. Dependencia de la nube

- 3 Visual Display: Más allá de los nits y el 8K

- 4 Movilidad y Software-Defined Vehicles (SDV)

- 5 El impacto en la privacidad y la ética del dato

El cambio de paradigma: De la computación en la palma a la computación en el entorno

El CES 2026 no ha sido una feria de dispositivos; ha sido el acta de defunción del modelo de interacción táctil que ha dominado los últimos quince años. Lo que hemos presenciado en Las Vegas este año es la consolidación de la IA encarnada (Embodied AI) y la transición definitiva hacia el hardware invisible. Ya no hablamos de pantallas que consumen nuestra atención, sino de entornos que anticipan nuestras necesidades mediante sensores de estado sólido y redes neuronales procesadas en el edge.

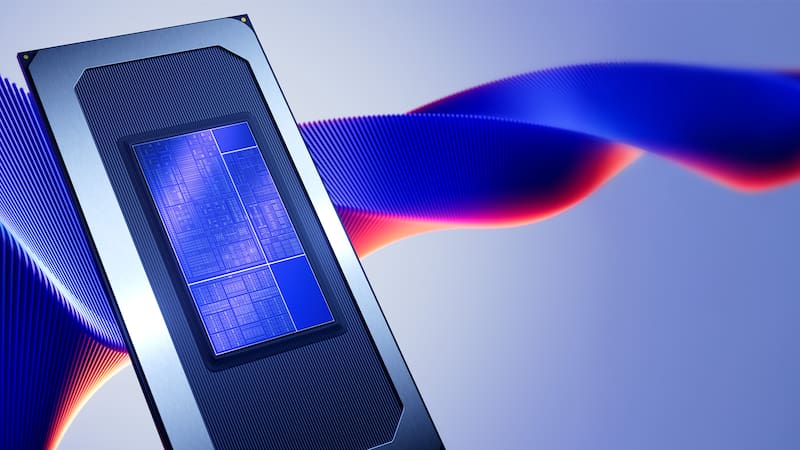

La geopolítica de los semiconductores ha dictado el ritmo de esta edición. Con la llegada de los procesos de litografía de 1.4 nanómetros a escala comercial, la eficiencia energética ha dejado de ser un cuello de botella para convertirse en el mayor habilitador de la historia de la electrónica de consumo. Hemos pasado de dispositivos que “consultan” a la nube a sistemas autónomos con LLMs (Large Language Models) locales capaces de razonamiento multimodal sin latencia perceptible.

La soberanía del NPU: Procesamiento local vs. Dependencia de la nube

La gran tendencia técnica ha sido la explosión de los LPUs (Language Processing Units) integrados en electrodomésticos y wearables. Si 2024 fue el año de los chatbots, 2026 es el año de la acción física controlada por lenguaje. Los fabricantes líderes han presentado arquitecturas donde el NPU (Neural Processing Unit) gestiona hasta 100 trillones de operaciones por segundo (TOPS) con un consumo inferior a los 2 vatios.

Lentes de contacto inteligentes con micro-LEDs de 0.01mm y una luminancia de hasta 5.000 nits para visualización a pleno sol.

Densidades energéticas de 500 Wh/kg que permiten autonomías de 48 horas en dispositivos de realidad mixta de menos de 80 gramos.

Visual Display: Más allá de los nits y el 8K

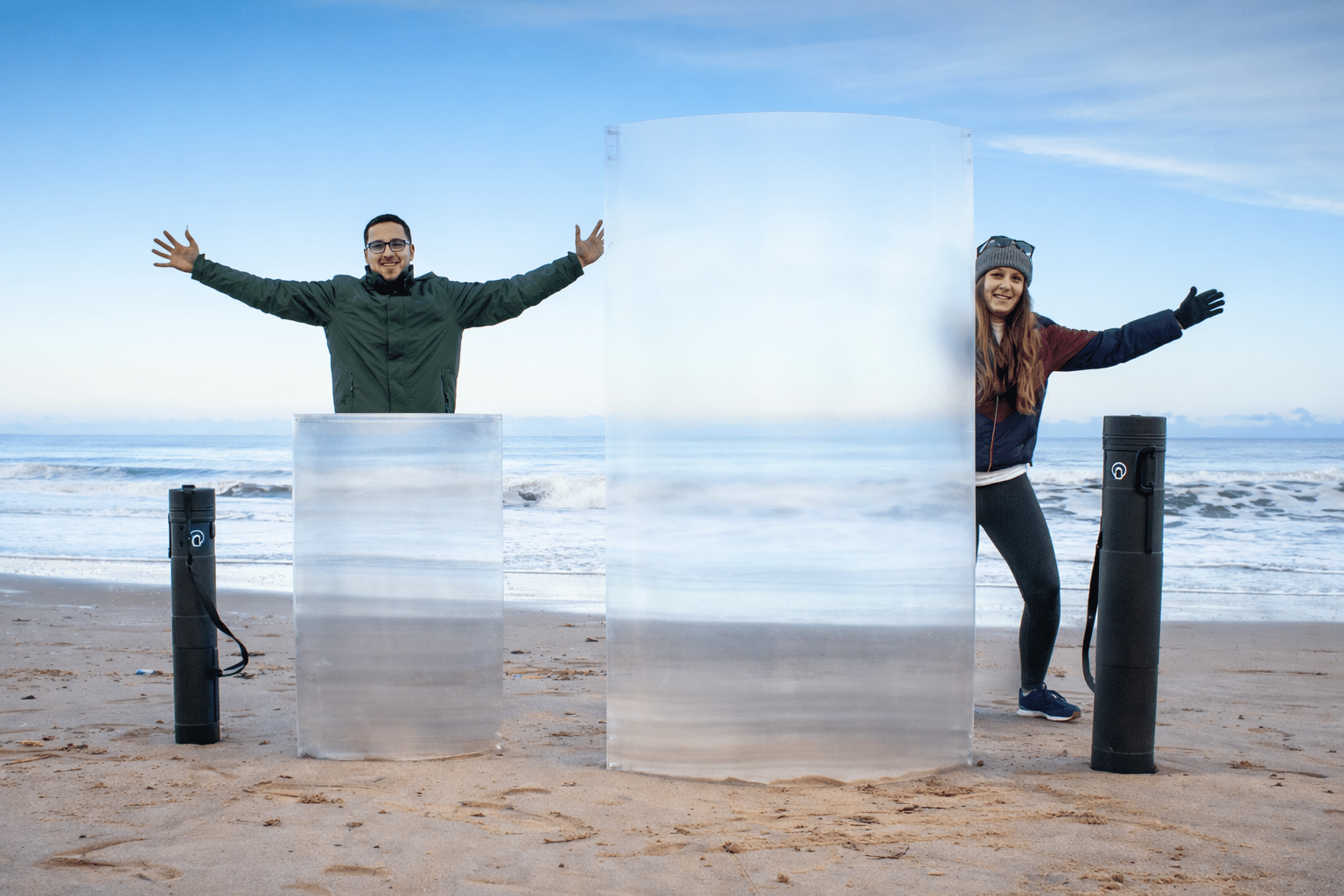

En el sector de los televisores y paneles, la batalla ya no se libra en la resolución. El ojo humano ha alcanzado su límite de discernimiento y la industria lo sabe. El enfoque este año ha sido la tecnología PVD (Physical Vapor Deposition) para la creación de paneles autoemisivos ultrafinos que pueden mimetizarse con cualquier superficie, incluyendo tejidos y cristales curvos.

Hemos visto prototipos funcionales de pantallas con retroalimentación háptica ultrasónica, capaces de proyectar texturas en el aire mediante ondas sonoras de alta frecuencia. Esto cambia las reglas del juego para la accesibilidad y la telemedicina, permitiendo al usuario “sentir” interfaces que no están físicamente allí.

Movilidad y Software-Defined Vehicles (SDV)

El coche ya no es un vehículo con ordenador; es un ordenador con ruedas. En el CES 2026, la estandarización del protocolo V2X (Vehicle-to-Everything) ha demostrado que la conducción autónoma de nivel 4 no es un sueño de Silicon Valley, sino una realidad logística inminente. La clave reside en la integración de radares de Lidar de estado sólido integrados directamente en el chasis, eliminando las protuberancias estéticas de antaño.

El impacto en la privacidad y la ética del dato

Como Redactores Jefes, no podemos ignorar la sombra que proyecta este despliegue técnico. La omnipresencia de sensores requiere una gobernanza de datos sin precedentes. La tendencia “Privacy-by-Design” ha sido un pilar en las conferencias clave: los nuevos estándares exigen que el procesamiento de biometría y patrones de comportamiento se realice exclusivamente en el enclave seguro del hardware, sin posibilidad de exportación a servidores de terceros.

Preguntas Frecuentes (FAQ) – CES 2026

Sin duda, la IA encarnada en robots domésticos de bajo coste. Gracias a los nuevos NPUs de alta eficiencia, hemos visto asistentes capaces de manipular objetos delicados con precisión quirúrgica por menos de 2.000 euros.

Aunque ya existen unidades comerciales para el sector B2B, se espera que la adopción masiva en hogares (sustituyendo ventanas o espejos) ocurra hacia el último trimestre de 2026.

No de forma inmediata, pero sí como dispositivo central. El CES 2026 ha demostrado que el ecosistema de wearables (gafas, anillos y parches inteligentes) está listo para asumir el 80% de las tareas que hoy delegamos en el teléfono.